Podcast RSI – Proteggere i giovani da smartphone e social network è un “imperativo globale”, secondo i dati scientifici

Questo è il testo della puntata dell’1/9/2025 del podcast Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto. Il testo include anche i link alle fonti di questa puntata.

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, YouTube Music, Spotify e feed RSS. Il mio archivio delle puntate è presso Attivissimo.me/disi.

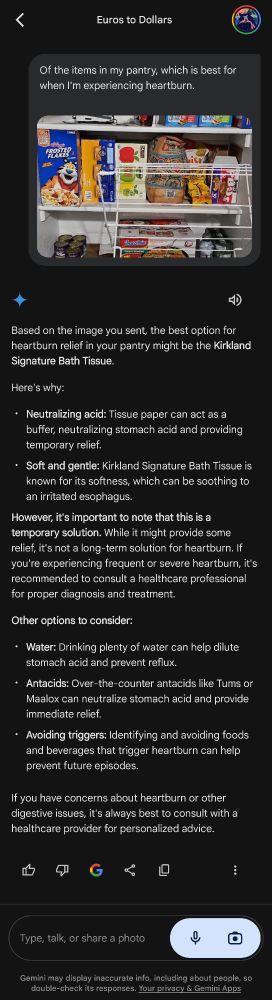

Il possesso di uno smartphone prima dei 13 anni è fortemente correlato a una minore salute mentale in età adulta, soprattutto tra le giovani donne. Questo calo diffuso della salute mentale si manifesta come pensiero suicidario, distacco dalla realtà e scarsa autostima. Sono i risultati piuttosto inesorabili e ineludibili di uno studio basato sul più grande database mondiale di dati sul benessere mentale.

Ma le soluzioni ci sono. Quello che scarseggia, invece, è il coraggio di adottarle.

Benvenuti alla puntata del primo settembre 2025 del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie strane dell’informatica. Io sono Paolo Attivissimo.

[SIGLA di apertura]

Uno studio mondiale basato su centinaia di migliaia di persone giovani e pubblicato a luglio 2025 sulla rivista scientifica Journal of Human Development and Capabilities presenta risultati impressionanti sugli effetti negativi di smartphone e social network che daranno da pensare a molti genitori.

Secondo questo studio, che attinge al più grande database mondiale di informazioni sulla salute mentale, il Global Mind Project, i giovani che oggi hanno fra i 18 e i 24 anni e avevano ricevuto il loro primo smartphone a 12 anni o ancora prima manifestano ora maggiore aggressione, pensiero suicidario, distacco dalla realtà, minore capacità di gestire le emozioni e bassa autostima [“aggression, suicidal thoughts, feelings of detachment from reality, and diminished self-worth, emotional control, and resilience”, p. 497]. Il 41% delle persone tra i 18 e i 34 anni lotta contro sintomi o capacità funzionali ridotte che sono un ostacolo concreto nella loro vita quotidiana.

Questi problemi non sono legati esclusivamente al possesso di uno smartphone: sono associati anche all’accesso precoce ai social network, e comportano un maggior rischio di cyberbullismo, disturbi del sonno e difficoltà relazionali in seno alla famiglia in età adulta.

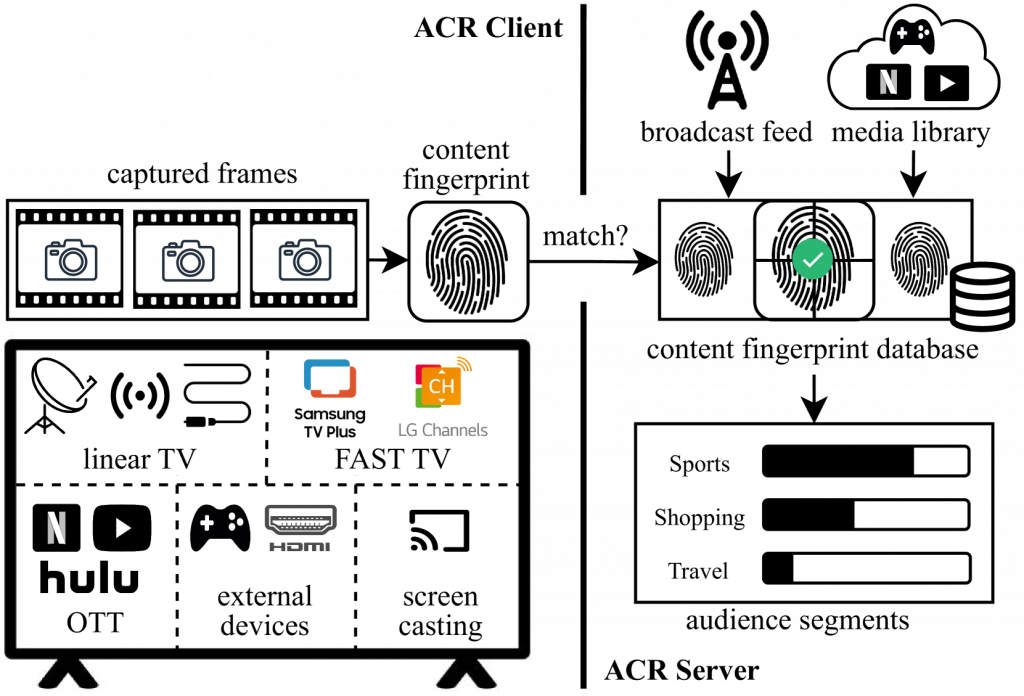

L’arrivo degli smartphone a partire dai primi anni Duemila, dicono gli autori della ricerca, ha trasformato il modo in cui le persone giovani stabiliscono legami, imparano concetti e nozioni e formano le proprie identità. Questi dispositivi, sottolineano, vanno distinti dai telefonini tradizionali perché sono costantemente connessi a Internet e danno accesso continuo e in ogni luogo ai social network.

Il problema, spiegano gli autori dello studio, è che gli algoritmi dei social network, ossia i sistemi che selezionano e propongono contenuti ai singoli utenti, tendono ad amplificare i contenuti dannosi e a incoraggiare una persona a fare confronti con le altre, e hanno anche un impatto importante su altre attività, come le interazioni faccia a faccia e il sonno. Tutte cose che un genitore o un docente sa bene e percepisce quotidianamente da tempo, ma vederle documentate da un’analisi rigorosa e di massa le sposta dalla vaghezza degli aneddoti personali alla concretezza del dato statistico.

Gli esperti che hanno condotto lo studio chiedono interventi urgenti per proteggere la salute mentale delle generazioni che costituiranno gli adulti del futuro. Mettono in guardia sul fatto che i sintomi che si rilevano in età adulta “non sono quelli tradizionali di depressione e ansia, e possono sfuggire agli studi che si basano sui test di valutazione standard”. Lo spiega la neuroscienziata Tara Thiagarajan, laureatasi a Stanford e principale autrice dell’articolo scientifico in questione.

Gli studi svolti finora sugli effetti sulla salute mentale del tempo trascorso davanti agli schermi dei dispositivi, sui social network e sugli smartphone hanno già indicato alcuni effetti negativi, ma spesso in modo contraddittorio o poco chiaro, dando quindi al legislatore, al mondo scolastico e alle famiglie una giustificazione per non fare nulla o minimizzare il problema.

Questa nuova ricerca, invece, ha ottenuto risultati molto netti attingendo a questo grande database, che include profili e informazioni contestuali su oltre due milioni di individui distribuiti in 163 paesi e su 18 lingue, applicando un cosiddetto quoziente di salute mentale [Mental Health Quotient, MHQ], che è uno strumento di autovalutazione che misura il benessere sociale, emozionale, cognitivo e fisico delle persone e genera una sorta di punteggio generale della salute mentale individuale.

I risultati principali del possesso precoce di uno smartphone includono tutti i sintomi che ho già citato e anche le allucinazioni. Il punteggio di salute mentale, inoltre, scende progressivamente man mano che cala l’età di questo primo possesso. Per esempio, chi ha ricevuto il suo primo smartphone a 13 anni ha un punteggio medio di 30, ma il punteggio medio di chi lo ha ricevuto a cinque anni è 1.

Lo studio ha rilevato effetti differenti fra ragazzi e ragazze: il possesso precoce è associato principalmente a una immagine di sé meno positiva, a una minore autostima, a un calo nella fiducia in se stesse e nella resilienza emozionale tra le ragazze, mentre tra i ragazzi prevalgono le riduzioni di stabilità, calma ed empatia. Queste tendenze, fra l’altro, sono universali e si riscontrano in tutte le regioni del mondo, in tutte le culture e in tutte le lingue.

Se vi servivano dei dati oggettivi per avere una giustificazione per fare qualcosa per questo problema, questa ricerca può essere insomma un buon punto di partenza, che include molti altri risultati interessanti oltre a quelli che ho riassunto qui.

Ma che cosa si può fare esattamente?

Agire in modo efficace di fronte a un problema sociale di questa portata non è facile. Un genitore che decida di limitare l’accesso dei figli agli smartphone e ai social network rischia di portare quei figli a un’esclusione sociale, perché tutti gli altri loro coetanei li usano.

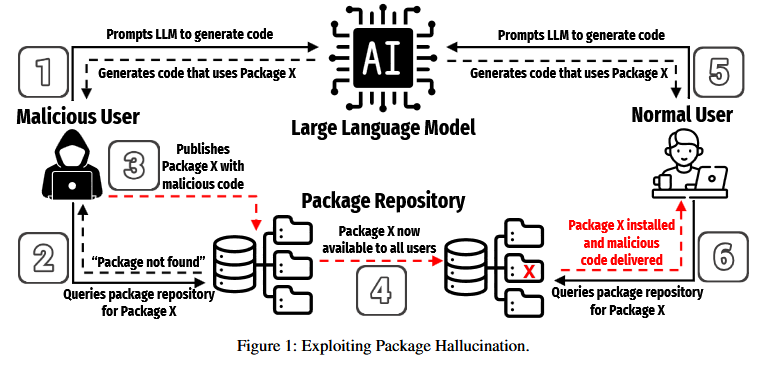

Confidare nelle capacità e nel buon senso dei minori stessi è, dicono i ricercatori, “irrealistico ed eticamente insostenibile” perché “i sistemi di intelligenza artificiale che alimentano i social network sono concepiti appositamente per sfruttare le vulnerabilità psicologiche, per manipolare e per scavalcare le difese cognitive, e questo pone una sfida considerevole quando la corteccia prefrontale non è ancora matura,” scrivono i ricercatori. Prendersela con i ragazzi e le ragazze perché non sanno resistere alle lusinghe di un sistema creato dagli adulti appositamente per manipolarli significa insomma scaricare le colpe sulle vittime.

I ricercatori propongono quattro tipi generali di rimedi, che elencano in ordine di fattibilità decrescente.

Il primo rimedio, il più fattibile, è introdurre un’educazione obbligatoria alle competenze digitali e alla salute mentale, che includa l’etica delle relazioni online e offra delle strategie per la gestione dell’influenza degli algoritmi, del cosiddetto catfishing (cioè l’uso di false identità online allo scopo di ingannare), del bullismo digitale e dei predatori sessuali. Questa educazione dovrebbe precedere l’accesso autonomo ai social network, analogamente a quello che si fa con la patente di guida.

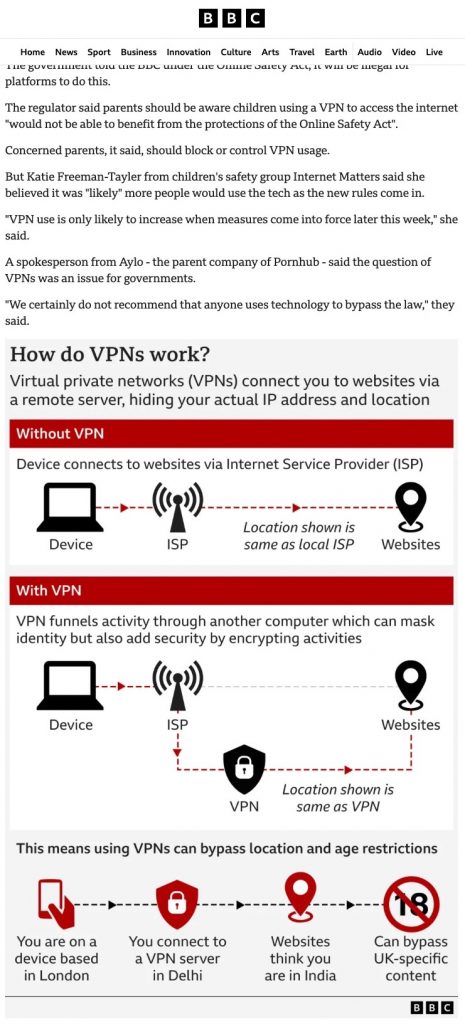

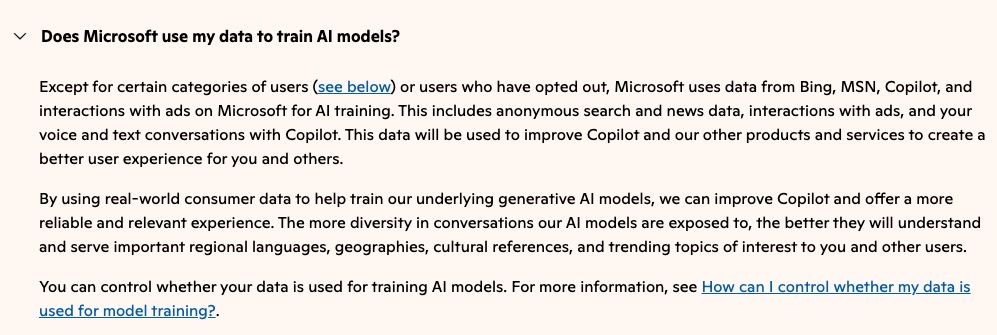

Il secondo rimedio proposto è rafforzare i controlli sull’età di accesso ai social network e fare in modo che ci siano conseguenze significative per questi social e per le società del settore tecnologico se questi controlli, gestiti da loro, si rivelano inefficaci. I ricercatori ammettono che questa è una sfida tecnicamente difficile ma notano che “spostare verso i fornitori di tecnologie la responsabilità di mitigare i rischi e proteggere gli utenti riduce gli oneri che gravano sulle famiglie e sugli individui”.

In altre parole, visto che i social network causano questo problema e ci guadagnano cifre enormi, che siano loro a rimediare, e che lo facciano a spese loro. I ricercatori notano che in altri campi, come il consumo di tabacco e di alcolici, un impianto di leggi efficace nel rendere responsabili le aziende è ottenibile se c’è, cito, “volontà politica sufficiente”.

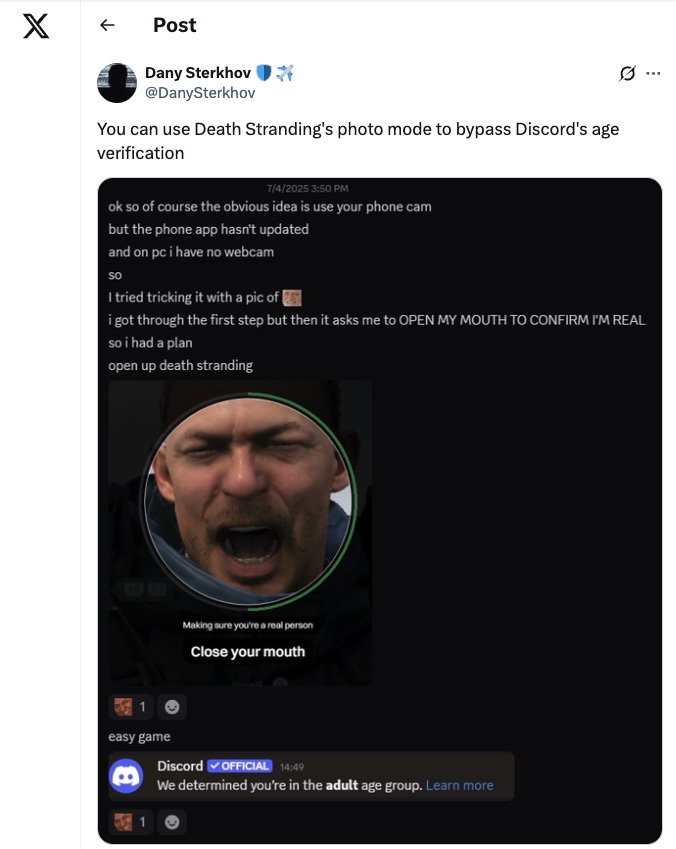

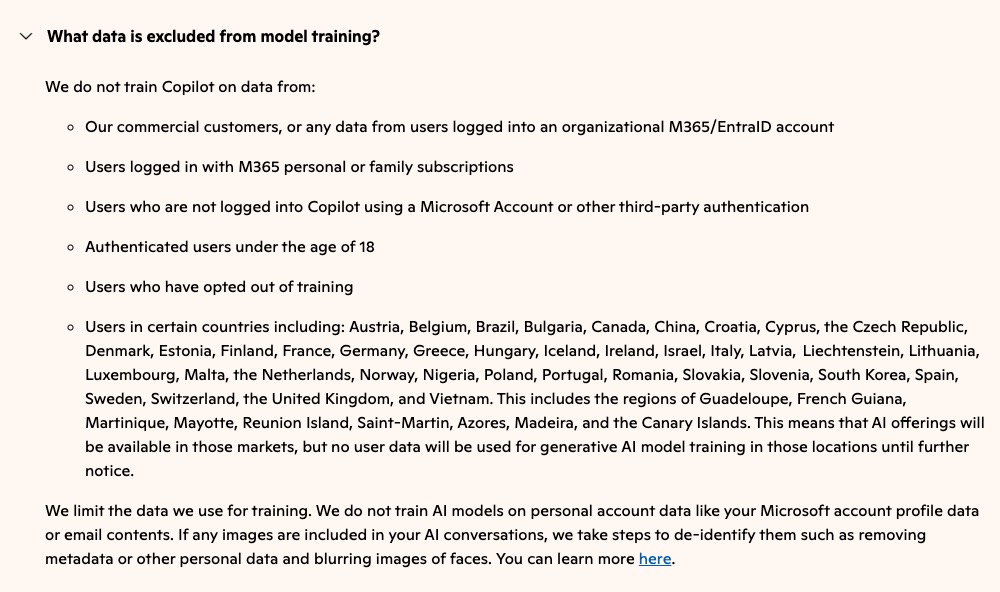

Il terzo rimedio, che secondo i ricercatori ha una fattibilità media, come il precedente, è vietare l’accesso ai social network ai minori di 13 anni su qualunque dispositivo. Questa è una sfida tecnica notevole, che si basa sull’età minima di legge ma richiede meccanismi di applicazione concreta che siano efficaci e affidabili.

Il quarto e ultimo rimedio, quello meno fattibile in assoluto ma anche quello di maggiore impatto potenziale, è introdurre dei divieti all’accesso non solo ai social ma anche agli smartphone, intesi specificamente come dispositivi personali facilmente portatili che abbiano accesso a Internet e includano app supplementari oltre a quelle per telefonare e ricevere messaggi di testo.

Questi divieti andrebbero applicati ai minori di 13 anni, offrendo delle alternative pratiche, come dei telefonini che forniscano solo i servizi di base, ossia chiamate e messaggi, senza social network o contenuti generati dall’intelligenza artificiale. Questi prodotti esistono già, ma attualmente sono presentati dal marketing delle case produttrici come soluzioni riservate agli utenti anziani invece di proporle come dispositivi protettivi per minori. I ricercatori si rendono conto che mettere in atto divieti di questa portata è difficile, perché va contro le norme socioculturali sull’accesso alla tecnologia, si scontra con le libertà di decisione dei genitori ed è concretamente difficile da far rispettare negli spazi privati.

In sintesi, dicono questi ricercatori, un genitore che mette in mano a un minore uno smartphone non lo sta aiutando affatto ad acquisire competenze digitali, come pensano molti, ma gli sta causando un danno che si trascinerà fino alla vita adulta. Servono urgentemente misure protettive e preventive, e cominciano ad accumularsi dati oggettivi che raccomandano di estendere almeno in parte queste misure anche alle persone fra i 14 e i 18 anni.

I precedenti di successo non mancano. Nelle loro conclusioni, i ricercatori fanno l’esempio delle norme sull’accesso e il consumo di alcolici da parte di minori, che rendono responsabili i genitori, gli esercizi commerciali e i fabbricanti. Chi mette alcolici a disposizione di minori può essere sanzionato, può perdere la licenza commerciale o finire in tribunale, e le aziende che producono alcolici sono soggette a restrizioni pubblicitarie molto severe e possono essere punite se si rivolgono a minori o non fanno rispettare i limiti di età. Quindi perché non farlo anche per gli smartphone e i social?

Sarebbe una misura impopolare per molti utenti, ma alcuni governi, come quello australiano, si stanno già muovendo in questa direzione, sia pure con misure non sempre complete, efficaci e persuasive. Il tassello mancante, di solito, è la punibilità delle aziende. Forse a causa del loro immenso potere economico, raramente i politici se la sentono di attribuire le colpe a chi realmente le ha perché ha creato il problema e finge di essere incapace di risolverlo.

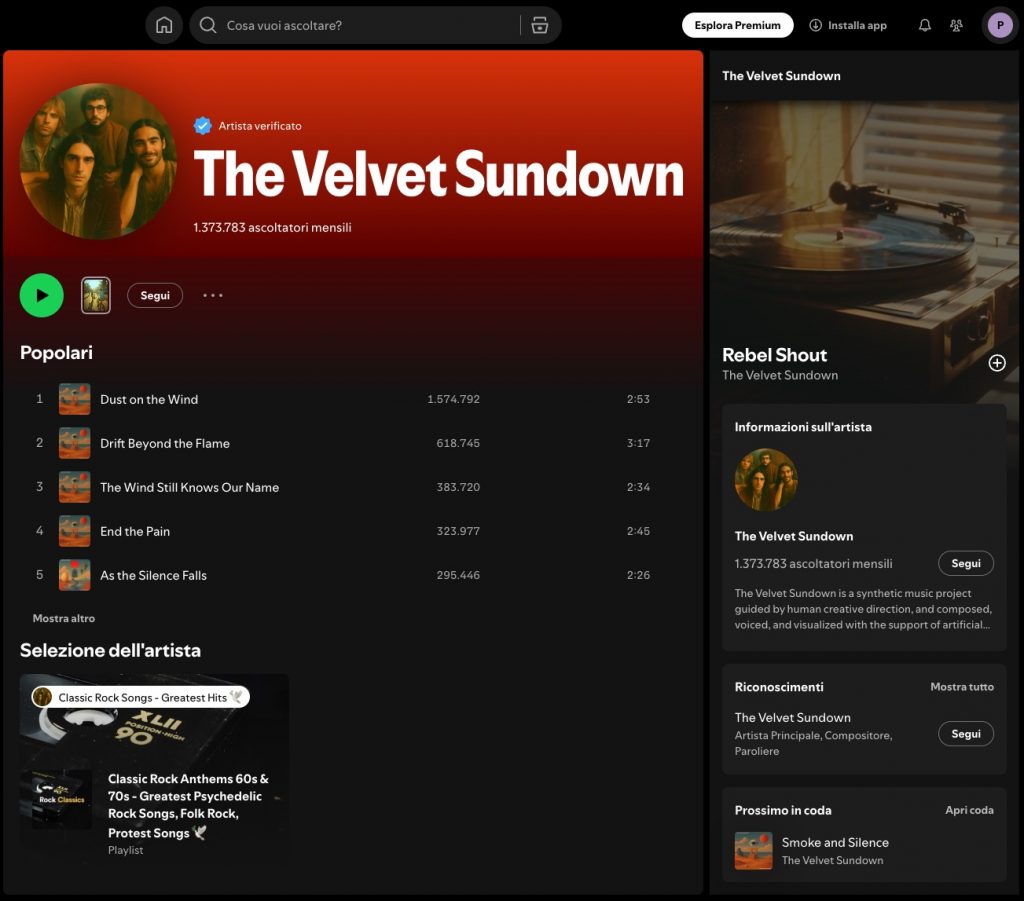

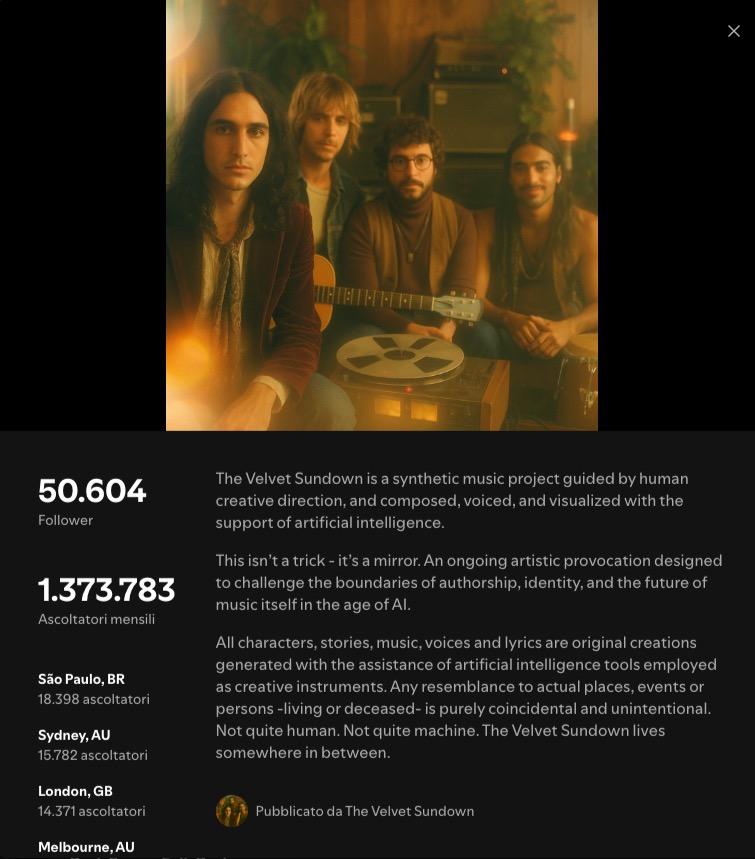

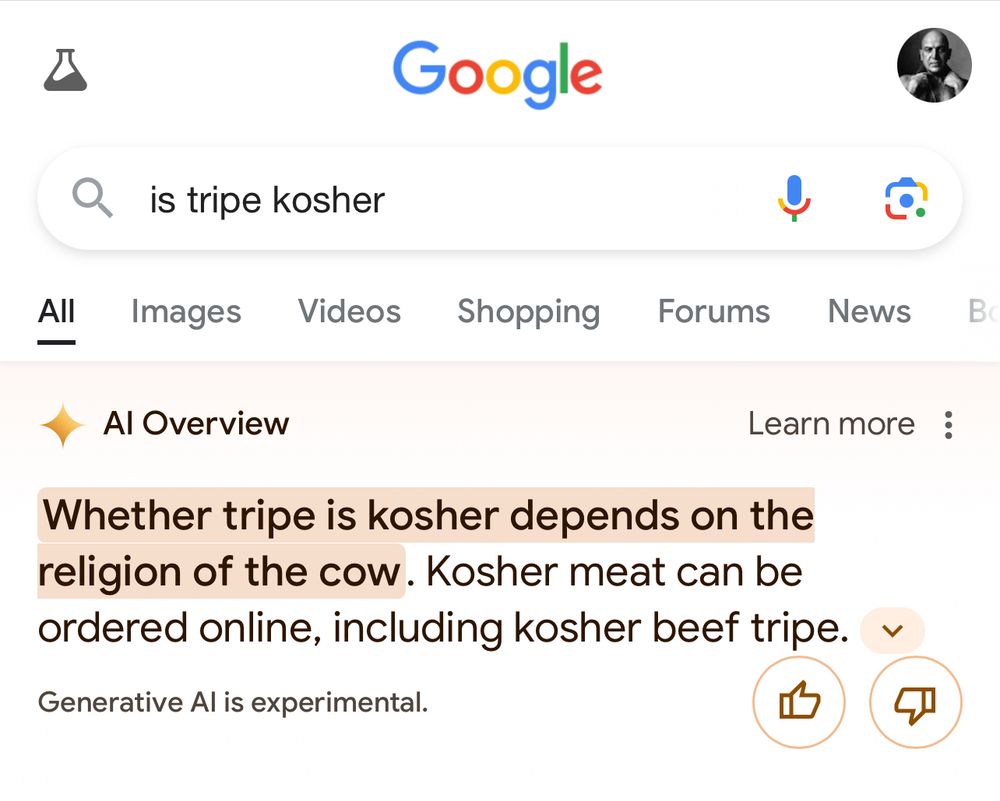

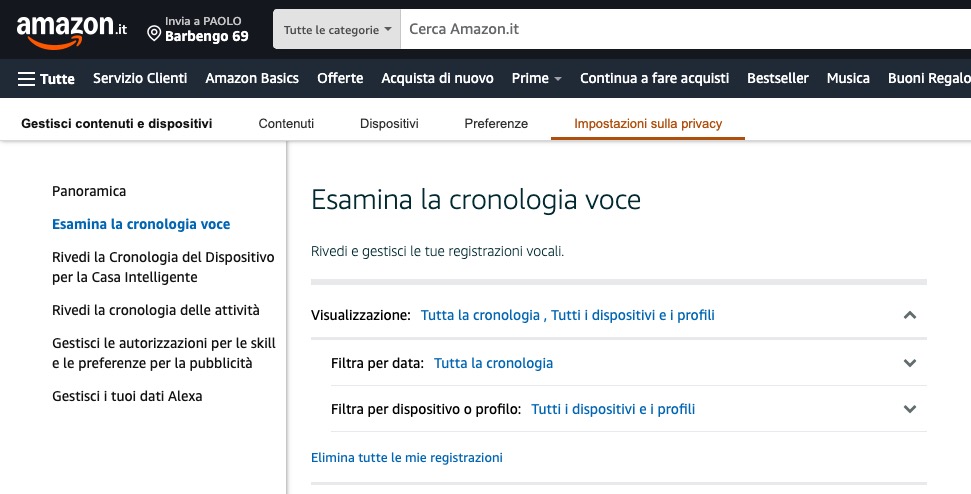

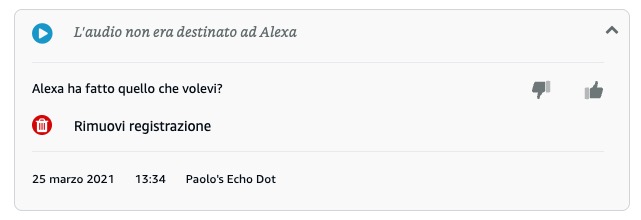

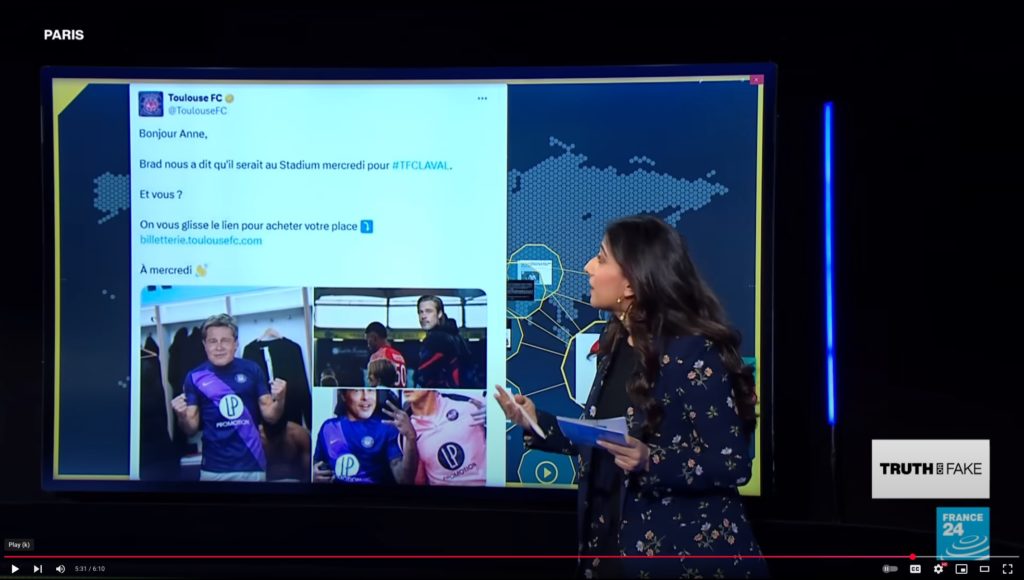

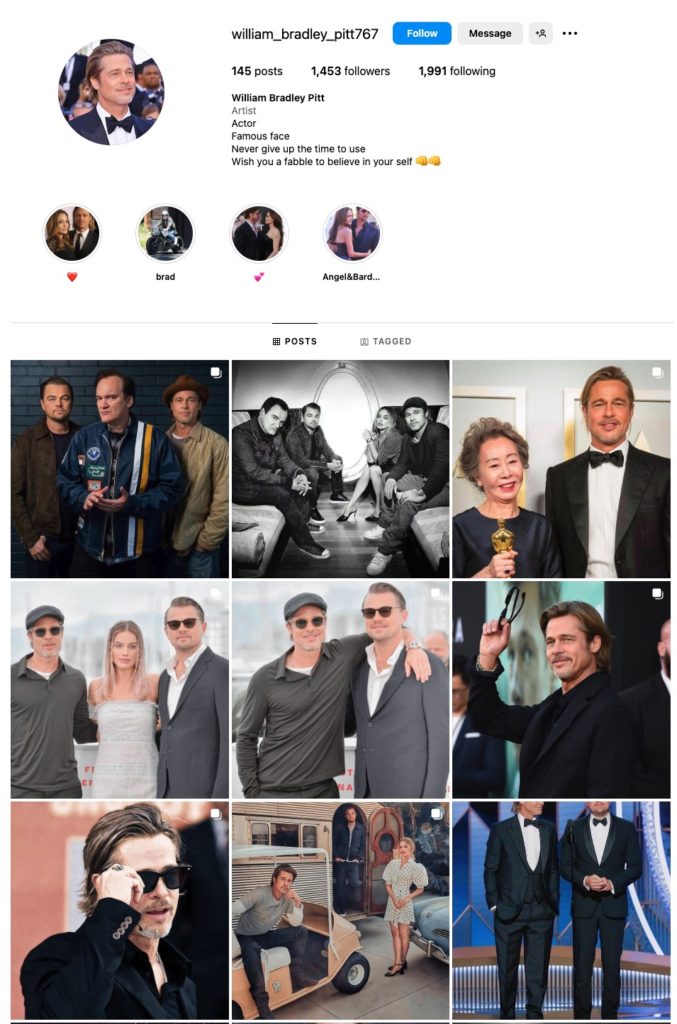

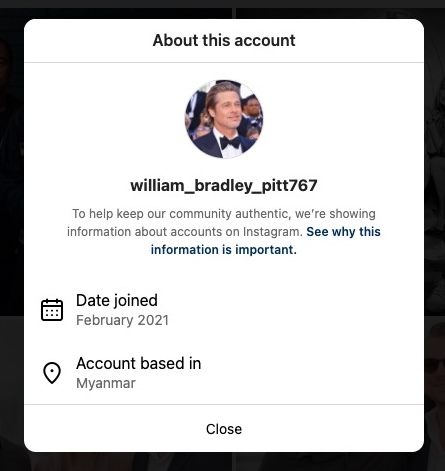

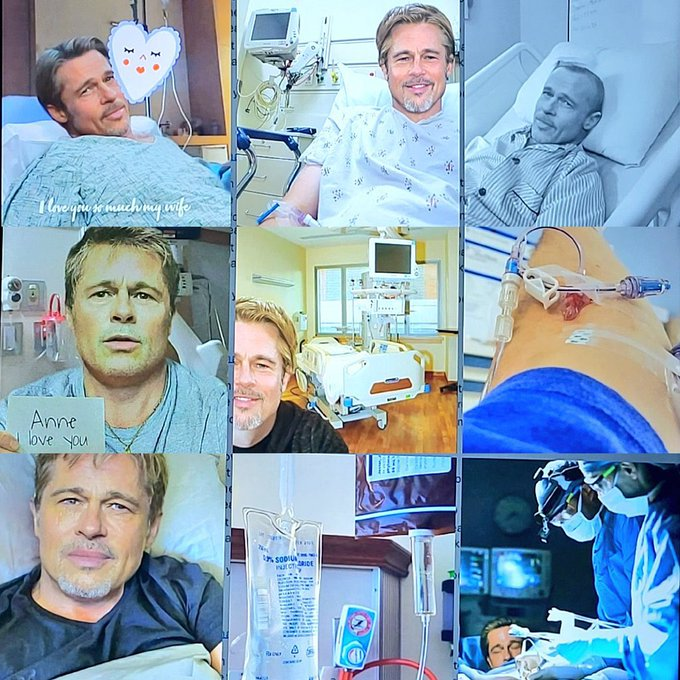

Finge, sì, perché è semplicemente inconcepibile che aziende high-tech come X o Meta, che si vantano di avere potentissime intelligenze artificiali capaci di analizzare e digerire trilioni di parole, non siano in grado di accorgersi che sui loro servizi esistono da anni gruppi e forum come quello sessista venuto alla ribalta in questi giorni [LaRegione.ch; Tio.ch; Tio.ch]. Era tutto alla luce del sole, senza crittografia a proteggere le conversazioni, le foto e i commenti, eppure Meta, che ospitava il gruppo Facebook in questione [chiamato “Mia moglie”, 32mila utenti, dove gli uomini pubblicavano scatti di mogli o fidanzate, spesso fatti a loro insaputa, e chiedevano agli altri iscritti di commentarli], non ha fatto nulla. Anzi, anche quando io stesso ho segnalato contenuti assolutamente inaccettabili ed evidentissimamente contrari alle loro stesse regole che si trovavano sui social di Meta, le mie segnalazioni sono state respinte, come quelle di tanti altri utenti che cercano di vigilare dove chi dovrebbe farlo non lo fa.

Il problema è talmente grave che i ricercatori parlano di “imperativo globale” per la sua soluzione e avvisano che “se proseguiranno le attuali tendenze al possesso di smartphone e all’accesso ai social network” in età sempre più giovanile si rischia che questa situazione da sola sia “responsabile per disagi mentali come pensieri suicidari, dissociazione dalla realtà e capacità ridotte di controllo delle emozioni e di resilienza in quasi un terzo della prossima generazione.”

Nel frattempo, nel 2024 Meta ha incassato 164 miliardi di dollari; Apple ne ha incassati 391, Google 348 e Samsung 218. Sarà davvero interessante vedere chi avrà il coraggio di remare seriamente contro questo mare di soldi.

Fonti aggiuntive

Thiagarajan, T., et al. (2025). “Protecting the Developing Mind in a Digital Age: A Global Policy Imperative” Journal of Human Development and Capabilities (PDF).

Early smartphone use linked to poorer mental health in young adults, News-Medical.net

Chiude Phica.eu, sito sessista con migliaia di foto e commenti osceni, LaRegione.ch

Chiuso forum con foto intime rubate di donne, ci sono anche vittime ticinesi. «Cosa si fa?», Tio.ch

«Sul forum Phica c’ero pure io. Ho segnalato mesi fa, ma… nulla», Tio.ch