Podcast RSI – Gli SMS di autenticazione segreti non sono affatto segreti: meglio abbandonarli

Questo è il testo della puntata del 23 giugno 2025 del podcast Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto. Il testo include anche i link alle fonti di questa puntata.

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, YouTube Music, Spotify e feed RSS. Il mio archivio delle puntate è presso Attivissimo.me/disi.

Il podcast va in pausa per due settimane e tornerà il 14 luglio.

[CLIP: audio di notifica di arrivo di un SMS]

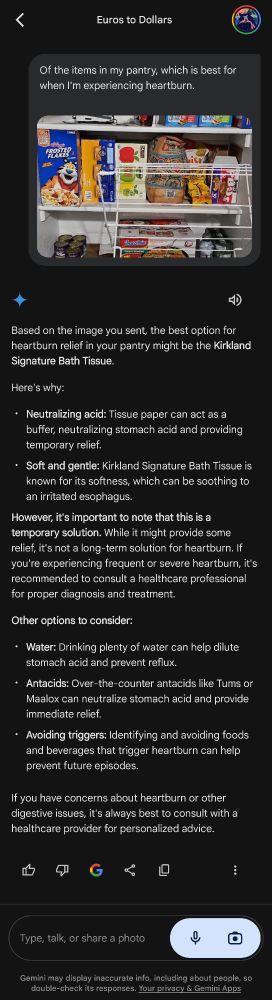

Usate gli SMS per ricevere i codici di sicurezza dei vostri account? Quegli SMS che vi ricordano insistentemente che quei codici non devono essere condivisi con nessuno? Beh, in realtà quei codici vengono spesso condivisi con qualcuno ancora prima di arrivare a voi, perché possono essere letti dagli intermediari che li trasmettono per conto delle grandi aziende che li usano, e quindi non sono affatto sicuri e segreti come molti pensano.

Questa è la storia di come gli SMS “di sicurezza” possono essere intercettati, permettendo di rubare account di posta o di accesso a servizi online di ogni genere anche quando sono protetti, almeno in apparenza, tramite l’autenticazione a due fattori. E al centro di questa storia c’è un bottino di un milione di SMS di autenticazione trafugati e c’è una società di telecomunicazioni svizzera. Ma questa è anche la storia di come si rimedia a questa falla sorprendente e inaspettata.

Benvenuti alla puntata del 23 giugno 2025 del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie strane dell’informatica. Io sono Paolo Attivissimo.

[SIGLA di apertura]

Gli SMS, intesi come messaggi di puro testo veicolati dalla rete telefonica cellulare, esistono da quasi quarant’anni, e resistono piuttosto bene alla frenetica evoluzione della tecnologia. Furono definiti nel 1986 dagli standard tecnici che diedero vita alla rete cellulare digitale GSM, e il primo SMS in assoluto fu inviato a dicembre del 1992, ma ci vollero alcuni anni prima che diventassero disponibili al pubblico i telefonini capaci di inviarli e i messaggini di testo diventassero un fenomeno di massa.

Oggi sembra quasi assurdo, ma all’epoca gli SMS si pagavano e spesso non era possibile mandarli a un numero estero o a quello di un altro operatore telefonico. Dopo un picco di utilizzo intorno al 2000, gli SMS sono stati in buona parte soppiantati e resi obsoleti dai messaggi gratuiti e molto meno limitati dei social network e dall’arrivo degli smartphone, ma ne vengono ancora inviati miliardi ogni mese nel mondo: non dagli esseri umani, ma dalle macchine.

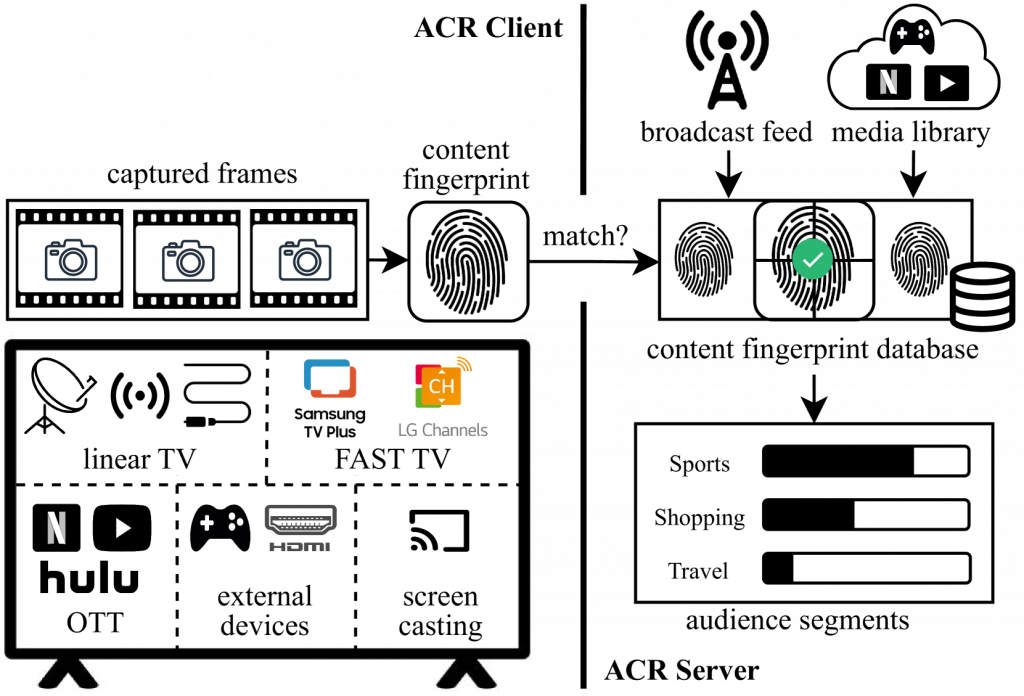

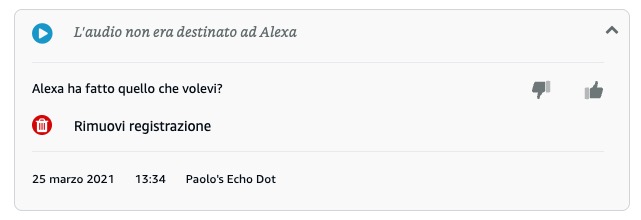

Moltissimi servizi online, infatti, oggi usano gli SMS per inviare agli utenti i codici temporanei di accesso ai loro servizi, per verificare le identità dei loro clienti, per notificare allarmi meteo o relativi al traffico, per validare gli acquisti e, purtroppo, anche per inviare pubblicità indesiderata.

Sono uno dei cardini dell‘autenticazione a due fattori, quella raccomandata dagli esperti di sicurezza per proteggere gli account di posta o social dai furti, perché viaggiano su un canale separato rispetto alla richiesta di password tradizionale. La password viene trasmessa via Internet, mentre il codice supplementare di sicurezza mandato in un SMS viaggia attraverso la rete telefonica tradizionale, e quindi un aspirante intruso o ladro di account dovrebbe riuscire a intercettare sia il traffico Internet del bersaglio, sia il suo traffico telefonico.

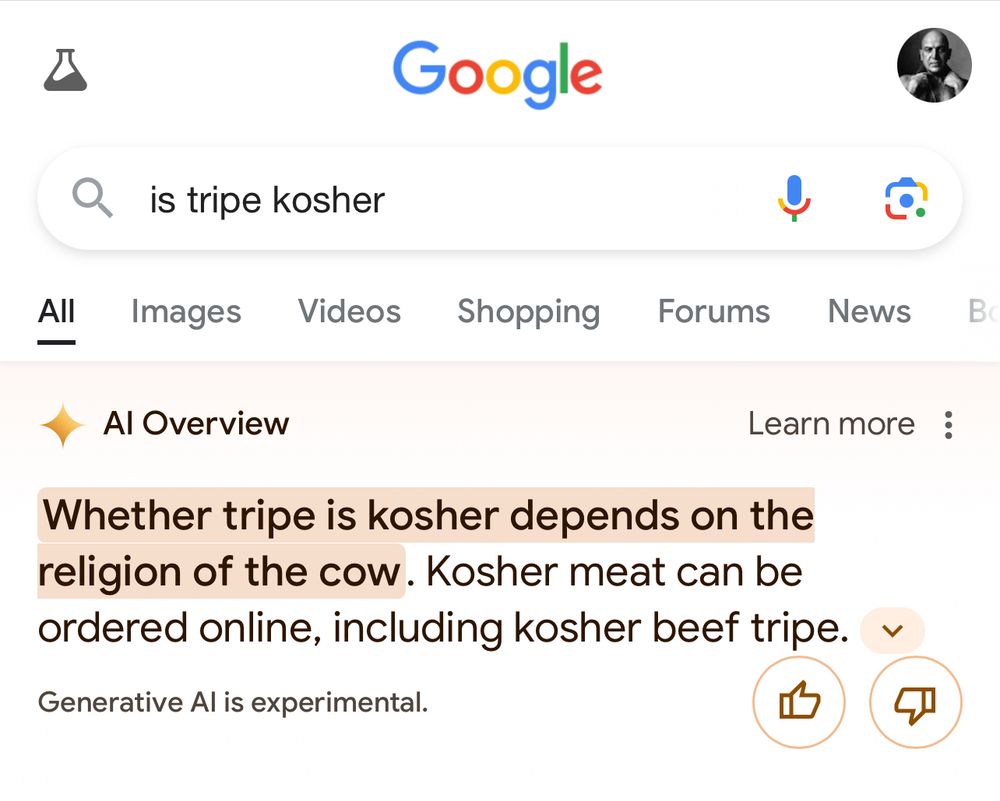

Ma un’indagine pubblicata pochi giorni da un gruppo di giornalisti chiamato Lighthouse Reports in collaborazione con Bloomberg Businessweek [paywall] ha rivelato il ventre molle di questo venerabile servizio di messaggistica.

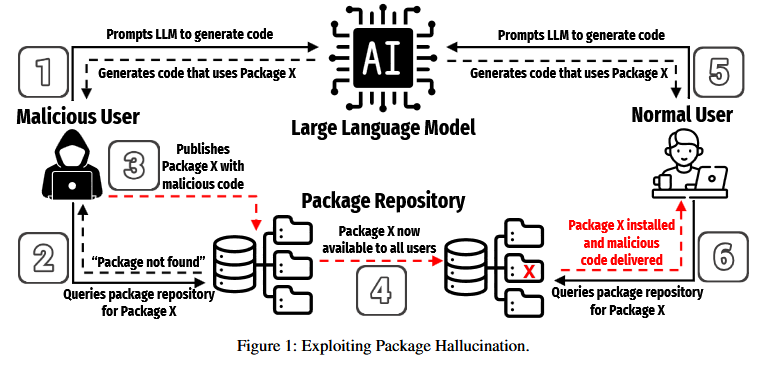

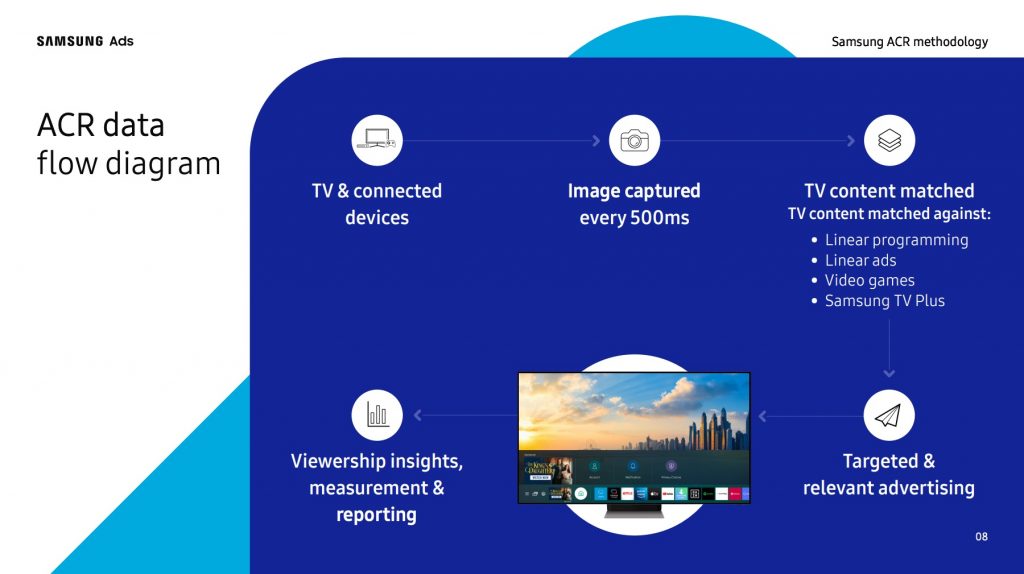

Quando un negozio online, una banca, un servizio di mail come Gmail o una piattaforma social come Instagram o Bluesky ci manda un SMS con i codici temporanei di autenticazione, in realtà non lo invia quasi mai direttamente a noi, come verrebbe spontaneo immaginare. Per contenere al massimo i costi, lo invia quasi sempre tramite società terze specializzate, degli intermediari, che a loro volta lo passano ad altri, fino a che finalmente arriva sul nostro schermo. Questo rimpallo è estremamente rapido, per cui non ce ne accorgiamo. Ma gli SMS vengono trasmessi in chiaro, ossia senza crittografia, e quindi ognuno di quegli intermediari può leggerne il contenuto senza che il mittente o il destinatario se ne possano accorgere.

E il contenuto di quegli SMS spesso include tutto quello che serve per rubare un account, perché assieme ai codici vengono inviati il numero di telefono del destinatario, per ovvie ragioni, e a volte anche il nome dell’account al quale si riferiscono. I codici segreti di autenticazione, insomma, non sono affatto segreti.

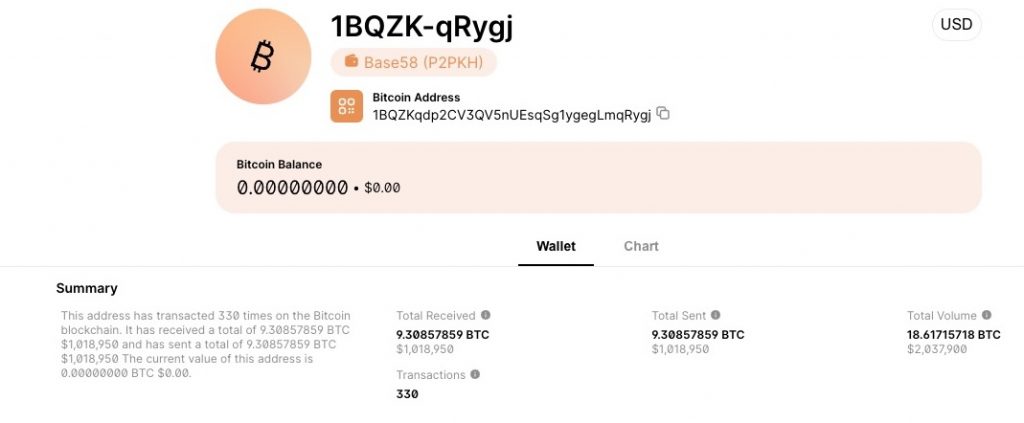

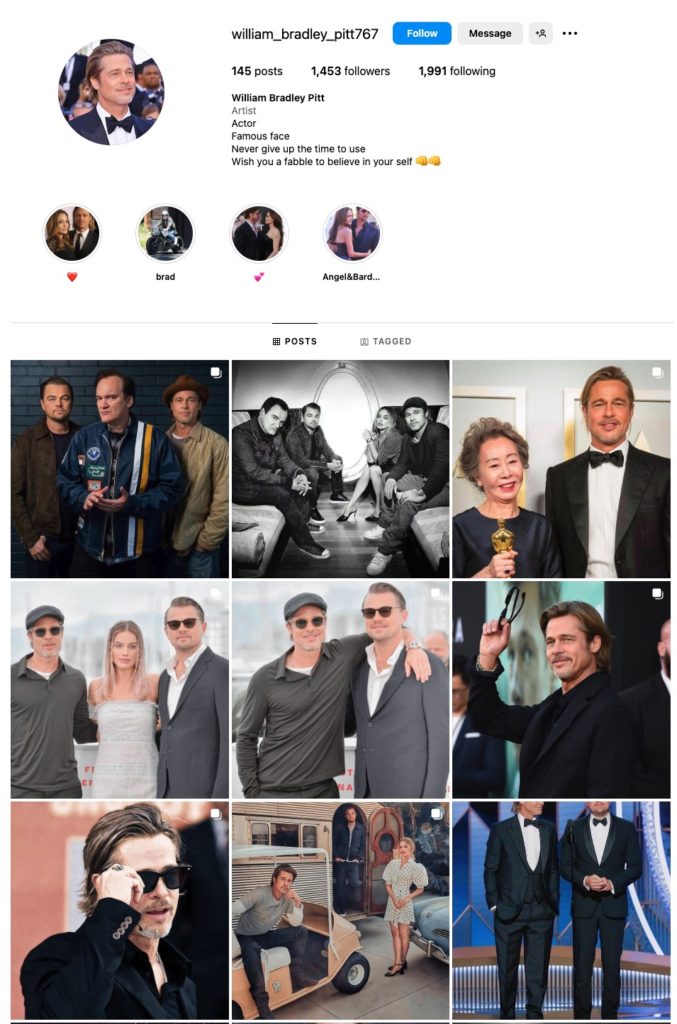

Se ne sono accorti l’anno scorso i giornalisti di Lighthouse Reports, appunto, quando hanno ricevuto da un addetto ai lavori, sotto anonimato e protezione giornalistica, un immenso archivio di SMS trafugati, che includevano circa un milione di messaggi contenenti codici di autenticazione a due fattori inviati intorno a giugno del 2023. Stando alle loro indagini, questi messaggi erano stati veicolati da una piccola società di telecomunicazioni svizzera, la Fink Telecom Services, che ha meno di dieci dipendenti. I mittenti erano Google, Meta, Amazon, banche europee, app come Tinder e Snapchat, servizi di scambi di criptovalute come Binance e persino servizi di messaggistica crittografata come Signal e WhatsApp. I destinatari, nota Bloomberg, erano situati in oltre 100 paesi in cinque continenti.

In altre parole, i nostri codici di sicurezza passano quasi sicuramente attraverso intermediari che non abbiamo mai sentito nominare.

Il problema è che questo settore è scarsamente regolamentato, ed è facilissimo diventare intermediari di miliardi di messaggi privati. In particolare, la Fink Telecom Services è nota agli esperti del settore per aver collaborato con agenzie di sorveglianza governative e con società specializzate nella sorveglianza digitale. Sempre Bloomberg sottolinea che “sia i ricercatori di sicurezza informatica, sia i giornalisti investigativi hanno pubblicato rapporti che accusano la Fink di essere coinvolta in vari casi di infiltrazione in account online privati.” Il CEO dell’azienda, Andreas Fink, respinge le accuse.

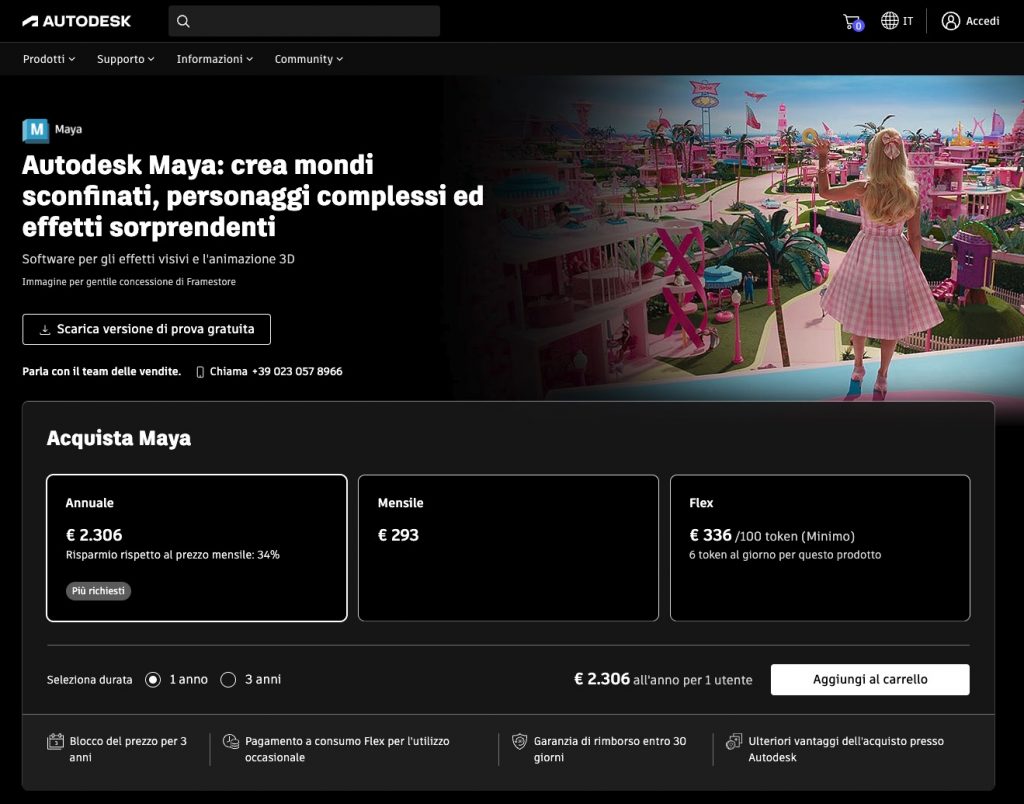

Le aziende che usano gli SMS per autenticare i propri servizi sono così ansiose di contenere i costi che si appoggiano a lunghe e intricate catene di intermediari non verificati, anche se sanno che questo è un comportamento pericoloso. Una delle principali organizzazioni di settore, il GSMA, ha pubblicato nel 2023 un codice di condotta che sconsiglia questa prassi proprio perché permetterebbe ai criminali di intercettare gli SMS contenenti i codici di sicurezza. Ma si tratta di un codice di condotta volontario, e sembra proprio che manchi la volontà diffusa di applicarlo.

Il rischio che deriva da questa carenza di volontà è tutt’altro che teorico. Nel 2020, per esempio, è emerso che una serie di attacchi informatici ai danni di investitori in criptovalute aveva usato proprio questa tecnica: un criminale informatico aveva ottenuto in questo modo i codici di autenticazione necessari per accedere agli account di mail e a quelli di gestione delle criptovalute di una ventina di persone in Israele. E ci sono altri casi documentati di intercettazioni e sorveglianze governative basate su questo approccio.

Purtroppo l’industria della trasmissione degli SMS, che si stima abbia un valore di oltre 30 miliardi di dollari, non ha strumenti legali che le consentano di scremare eventuali intermediari disonesti. I grandi utenti, ossia le aziende, appaltano gli invii dei loro codici di autenticazione a uno di questi intermediari e non hanno modo di sapere se questi invii vengono subappaltati e se quel subappaltatore a sua volta cede il contratto a terzi, e così via, in un complicato gioco internazionale di scatole cinesi e di società che spesso non hanno nemmeno bisogno di una licenza per operare.

E i nostri codici di sicurezza viaggiano così in questo mare burrascoso come messaggi in bottiglia che tutti possono leggere, mentre noi crediamo di aver protetto i nostri account attivando gli SMS di autenticazione.

Per fortuna ci sono delle soluzioni.

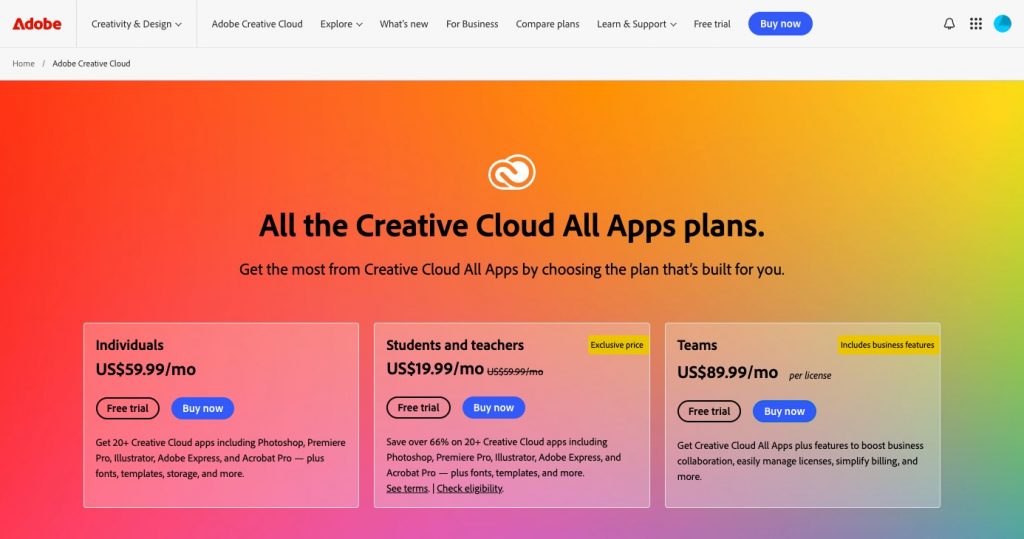

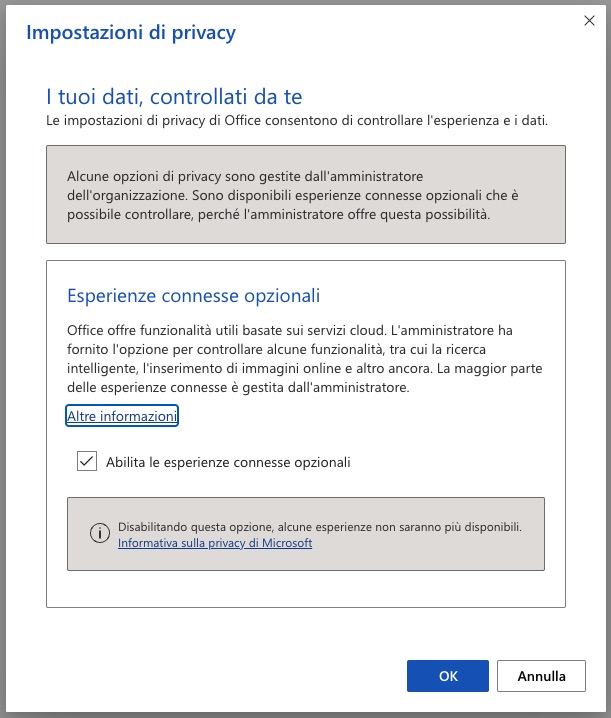

Di fronte a questa situazione caotica e insicura degli SMS tradizionali, gli esperti di sicurezza raccomandano alternative più robuste. In molti casi si possono attivare dei PIN supplementari sui propri account, e molti grandi nomi dei servizi online, come Google o Meta, offrono soluzioni di autenticazione che fanno a meno degli SMS e anzi stanno incoraggiando gli utenti ad abbandonare la ricezione di codici tramite messaggi telefonici tradizionali.

Una delle soluzioni più efficaci è l’uso di una app di autenticazione, come quelle di Google [Android; iOS] e Microsoft [Android; iOS], che si chiamano entrambe Authenticator, oppure Authy di Twilio. Per usarla, si entra nel proprio account del servizio che si vuole proteggere e lo si imposta in modo che non mandi un SMS con dei codici di verifica ma richieda un codice generato dall’app di autenticazione. Quel codice dura un minuto e poi viene cambiato automaticamente, e la sincronizzazione fra l’app e il sito si fa semplicemente inquadrando una volta con il telefono un codice QR.

Un altro metodo è l’uso di chiavi di sicurezza hardware: degli oggetti fisici, simili a chiavette USB, che si inseriscono nel computer, tablet o telefonino oppure si tengono vicini a uno di questi dispositivi per autorizzarlo ad accedere a un servizio online. Costano qualche decina di euro o franchi e diventano una sorta di portachiavi elettronico.

Queste soluzioni offrono maggiore sicurezza rispetto alla situazione colabrodo attuale degli SMS, ma in cambio richiedono un po’ di attenzione in più da parte dell’utente e, nel caso della chiave hardware comportano anche una piccola spesa.

Hanno anche un altro limite: accentrano tutti i codici in un’unica app o un unico dispositivo, per cui se si perde o rompe il telefonino o la chiave hardware si rischia di perdere accesso a tutti i propri account, mentre gli SMS invece arrivano sempre e comunque e sono separati per ogni account. Ma anche qui ci sono dei rimedi: si possono avere copie multiple dell’app di autenticazione su telefonini differenti o su più di una chiave hardware, un po’ come si fa con le chiavi della porta di casa, di cui è prassi normale avere almeno un paio di esemplari.

Se avete in casa un vecchio smartphone che non usate più perché la batteria non regge, potete recuperarlo facendolo diventare il vostro autenticatore di scorta, da lasciare a casa al sicuro in un cassetto e da usare in caso di furto o guasto dello smartphone principale.

Le soluzioni, insomma, ci sono. Ma resta la constatazione amara che le società più ricche del pianeta, come Google, Amazon o Meta, non sono disposte a spendere per garantire meglio la sicurezza dei propri utenti e continuano ad appoggiarsi a questa ingarbugliata rete di intermediari e sottointermediari invece di prendere il toro per le corna e mandare gli SMS di autenticazione direttamente. Tanto se perdiamo accesso ai nostri dati sui loro server, se ci saccheggiano il conto PayPal o Twint o quello in criptovalute, se perdiamo il controllo dei nostri profili social o qualcuno si legge tutta la nostra mail, il problema è nostro, non loro. E quindi, cinicamente, a queste grandi aziende conviene barattare la nostra sicurezza in cambio di un loro risparmio.

È dunque il caso di rimboccarsi le maniche virtuali e abbandonare gli SMS, pensando in prima persona alla propria protezione digitale, senza aspettare che lo faccia qualcuno per noi.