Questo è il testo della puntata del 14 aprile 2025 del podcast Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto. Il testo include anche i link alle fonti di questa puntata.

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, YouTube Music, Spotify e feed RSS. Il mio archivio delle puntate è presso Attivissimo.me/disi.

La prossima puntata verrà pubblicata il 28 aprile (lunedì 21 non ci sarà un nuovo podcast).

Va di moda, nel mondo informatico, appoggiarsi alle intelligenze artificiali per creare programmi risparmiando tempo, denaro e risorse umane e mentali. Ma questo nuovo metodo di lavoro porta con sé nuove vulnerabilità, che spalancano le porte ai criminali informatici più sofisticati in maniere inaspettate e poco intuitive ma devastanti.

Per infettare uno smartphone, un tablet o un computer non serve più convincere la vittima a installare un’app di provenienza non controllata, perché il virus può essere già presente nell’app originale. Ce lo ha messo, senza rendersene conto, l’autore dell’app; o meglio, ce lo ha messo l’intelligenza artificiale usata da quell’autore.

Questa è la storia di una di queste nuove vulnerabilità consentite dall’intelligenza artificiale: il cosiddetto slopsquatting, da conoscere anche se non si è sviluppatori o programmatori, per evitare che l’entusiasmo per la IA permetta ai malviventi online di insinuarsi nei processi aziendali eludendo le difese tradizionali.

Benvenuti alla puntata del 14 aprile 2025 del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie strane dell’informatica. Io sono Paolo Attivissimo.

[SIGLA di apertura]

La sicurezza informatica è una gara fra guardie e ladri, dove quasi sempre i ladri agiscono e le guardie reagiscono. I criminali inventano una tecnica di attacco e gli esperti di sicurezza la studiano per trovare il modo di neutralizzarla. Ma non è sempre così. In questa puntata vi racconto un caso in cui le guardie giocano d’anticipo, in maniera creativa e originale, immaginando un tipo di attacco nuovo e fornendo gli strumenti per bloccarlo ancora prima che i criminali riescano a metterlo in atto.

Chi crea programmi si affida oggi sempre più spesso all’intelligenza artificiale come assistente per la scrittura delle parti più tediose e ripetitive. C’è anche chi si affida totalmente alle IA e genera programmi senza saper programmare, nel cosiddetto vibe coding di cui ho parlato nella puntata del 31 marzo scorso. Copilot, ChatGPT e Cursor sono solo alcuni esempi di questi assistenti.

Ma anche senza arrivare a delegare tutto alle intelligenze artificiali, questo comportamento crea una nuova opportunità di attacco informatico con una tecnica originale e inaspettata, difficile da immaginare per una persona non addetta ai lavori. Questa tecnica si chiama slopsquatting: un nome coniato dall’esperto di sicurezza Seth Larson.

Il termine unisce due parole inglesi già molto usate in informatica: la prima è slop, che significa “sbobba, brodaglia” e viene usata in senso dispregiativo per indicare il prodotto mediocre, scadente e pieno di errori di molte intelligenze artificiali in vari settori. Una foto sintetica in cui il soggetto ha sei dita, per esempio, o ha una pelle che sembra fatta di plastica, è un tipico caso di slop. La maggior parte della gente non si accorgerà dell’errore o della scarsa qualità e accetterà la sbobba; anzi, a furia di mangiare solo quella si abituerà e la considererà normale.

Nella programmazione assistita dall’intelligenza artificiale, lo slop è un pezzo di codice generato che funziona, sì, ma è inefficiente o vulnerabile oppure non è in grado di gestire alcune situazioni particolari.

La seconda parola che definisce questa nuova forma di attacco è squatting: non c’entra la ginnastica, perché in informatica lo squatting è la pratica consolidata da tempo di occupare una risorsa, per esempio un nome di un sito, al solo scopo di infastidire, truffare o estorcere denaro. Chi compra nomi di dominio o di profili social che corrispondono a nomi di aziende o di celebrità per impedire che lo facciano i legittimi titolari di quei nomi, o allo scopo di chiedere soldi per cederglieli senza attendere le vie legali, fa squatting. I criminali che registrano nomi di siti simili a quelli ufficiali, contando sul fatto che molta gente sbaglia a digitare e sbaglia in modo prevedibile, finendo sui siti dei criminali e immettendovi le proprie password perché crede di essere nel sito ufficiale, fa typosquatting, perché l’errore di battitura in inglese è chiamato typo.

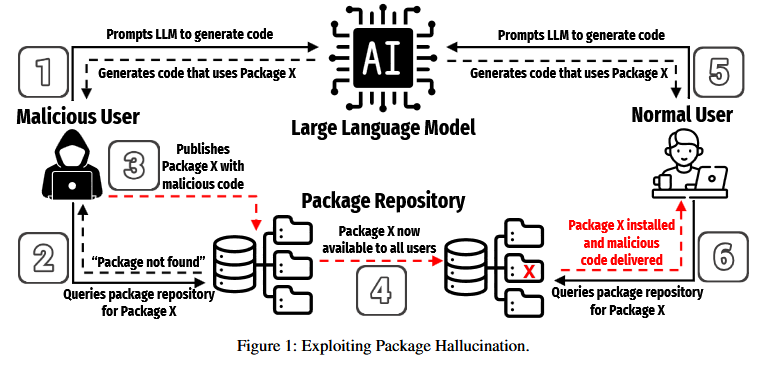

Lo slopsquatting, questa nuova tecnica di attacco al centro di questa storia, è un misto di questi due concetti. In pratica, il criminale crea e pubblica online una risorsa di programmazione malevola, un cosiddetto package o pacchetto, che ha un nome molto simile a quello di una risorsa attendibile e poi aspetta che l’intelligenza artificiale che crea codice di programmazione sbagli e usi per errore quella risorsa malevola al posto di quella genuina.

Chi crea software, infatti, raramente scrive tutto il codice da zero: di solito attinge a funzioni preconfezionate da altri e ampiamente collaudate, che appunto prendono il nome di pacchetti e sono pubblicate online in siti appositi. Ma se l’intelligenza artificiale sbaglia e attinge invece a un pacchetto pubblicato dai criminali con un nome ingannevole, senza che nessuno se ne accorga, il codice ostile dei malviventi verrà integrato direttamente nell’app ufficiale.

In altre parole, il cavallo di Troia informatico, ossia l’app malevola, non arriva dall’esterno, cosa che genera ovvie e facili diffidenze, ma viene costruito direttamente dal creatore originale dell’app senza che se ne renda conto. E a nessuno viene in mente di pensare che l’app ufficiale possa essere infetta e possa essa stessa aprire le porte ai ladri: è quindi un canale di attacco subdolo e letale.

Ma come fa un’intelligenza artificiale a commettere un errore del genere? È semplice: le intelligenze artificiali attuali soffrono di quelle che vengono chiamate in gergo allucinazioni. Per loro natura, a volte, producono risultati sbagliati ma a prima vista simili a quelli corretti. Nel caso delle immagini generate, un’allucinazione può essere una mano con sei dita; nel caso del testo generato da una IA, un’allucinazione può essere una parola che ha un aspetto plausibile ma in realtà non esiste nel vocabolario; e nel caso del codice di programmazione, un’allucinazione può essere una riga di codice che richiama un pacchetto di codice usando un nome sbagliato ma simile a quello giusto.

A prima vista sembra logico pensare che i criminali che volessero approfittare di questo errore dovrebbero essere incredibilmente fortunati, perché dovrebbero aver creato e pubblicato un pacchetto che ha esattamente quello specifico nome sbagliato generato dall’allucinazione dell’intelligenza artificiale. Ma un articolo tecnico pubblicato un mese fa, a marzo 2025 [We Have a Package for You! A Comprehensive Analysis of Package Hallucinations by Code Generating LLMs, disponibile su Arxiv.org], da un gruppo di ricercatori di tre università statunitensi rivela che gli sbagli delle IA tendono a seguire degli schemi sistematici e ripetibili e quindi non è difficile prevedere quali nomi verranno generati dalle loro allucinazioni.

Secondo questi ricercatori, “questa ripetibilità […] rende più facile identificare i bersagli sfruttabili per lo slopsquatting osservando soltanto un numero modesto di generazioni. […] Gli aggressori non hanno bisogno di […] scovare per forza bruta i nomi potenziali: possono semplicemente osservare il comportamento [delle IA], identificare i nomi comunemente generati dalle loro allucinazioni, e registrarseli.”

Un altro problema documentato dai ricercatori è che i nomi generati per errore sono “semanticamente convincenti”: il 38% ha, in altre parole, nomi somiglianti a quelli di pacchetti autentici. E comunque in generale hanno un aspetto credibile. Questo rende difficile che gli sviluppatori possano accorgersi a occhio di un errore.

C’è poi un terzo aspetto di questo problema di sicurezza: se uno specifico errore in un nome di pacchetto generato si diffonde e diventa popolare, perché per esempio viene consigliato spesso dalle intelligenze artificiali e nei tutorial pubblicati senza verifiche, e a quel punto un aggressore registra quel nome, le intelligenze artificiali finiranno per suggerire inconsapevolmente di attingere proprio al pacchetto malevolo, e per i criminali diventerà molto facile sfruttare massicciamente questa tecnica.

Se poi chi crea il software non sa programmare ma si affida totalmente alla IA, tenderà a fidarsi ciecamente di quello che l’intelligenza artificiale gli suggerisce. Come spiegano i ricercatori, “Se la IA include un pacchetto il cui nome è generato da un’allucinazione e sembra plausibile, il percorso di minima resistenza spesso è installarlo e non pensarci più”. E se nessuno controlla e nessuno ci pensa più, se nessuno si chiede “A cosa serve esattamente questo pacchetto richiamato qui?”, o se la domanda viene posta ma la risposta è “Boh, non lo so, ma il programma funziona, lascialo così”, il software ostile creato dai criminali diventerà parte integrante del software usato in azienda.

Di fronte a un attacco del genere, le difese tradizionali dell’informatica vacillano facilmente. È l’equivalente, nel mondo digitale, di sconfiggere un esercito non con un attacco frontale ma intrufolandosi tra i suoi fornitori e dando ai soldati munizioni sottilmente difettose.

Per fortuna gli addetti ai lavori in questo caso hanno anche qualche idea su come proteggersi da questa nuova tecnica.

I ricercatori che hanno documentato questo comportamento pericoloso dei generatori di codice hanno inoltre scoperto che ci sono alcune intelligenze artificiali, in particolare GPT-4 Turbo e DeepSeek, che sono in grado di riconoscere i nomi dei pacchetti sbagliati che essi stessi hanno generato, e lo fanno con un’accuratezza superiore al 75%. Conviene quindi prima di tutto far rivedere alle intelligenze artificiali il codice che hanno prodotto, e già questo è un passo avanti fattibile subito.

Inoltre le aziende del settore della sicurezza informatica hanno già preparato degli strumenti appositi, che si installano nell’ambiente di sviluppo e nel browser e sono in grado di rilevare i pacchetti ostili ancora prima che vengano integrati nel programma che si sta sviluppando. Una volta tanto, le guardie sono in anticipo sui ladri, che finora non sembrano aver sfruttato questa tecnica.

Come capita spesso, insomma, le soluzioni ci sono, ma se chi ne ha bisogno non sa nemmeno che esiste il problema, difficilmente cercherà di risolverlo, per cui il primo passo è informare della sua esistenza. E come capita altrettanto spesso, lavorare al risparmio, eliminando gli sviluppatori umani competenti e qualificati per affidarsi alle intelligenze artificiali perché costano meno e fanno fare bella figura nel bilancio annuale dell’azienda, introduce nuovi punti fragili che devono essere protetti e sono difficilmente immaginabili da chi prende queste decisioni strategiche, perché di solito non è un informatico.

Il problema centrale dello slopsquatting non è convincere gli informatici: è convincere i decisori aziendali. Ma questa è una sfida umana, non tecnica, e quindi il Disinformatico si deve fermare qui. Speriamo in bene.

Fonti

Risky Bulletin: AI slopsquatting… it’s coming!, Risky.biz, 2025

The Rise of Slopsquatting: How AI Hallucinations Are Fueling a New Class of Supply Chain Attacks, Socket.dev, 2025