L’IA di Meta non sa nemmeno le preghierine. Quanti fantastiliardi ci hanno speso?

Ultimo aggiornamento: 2025/06/27 8:25.

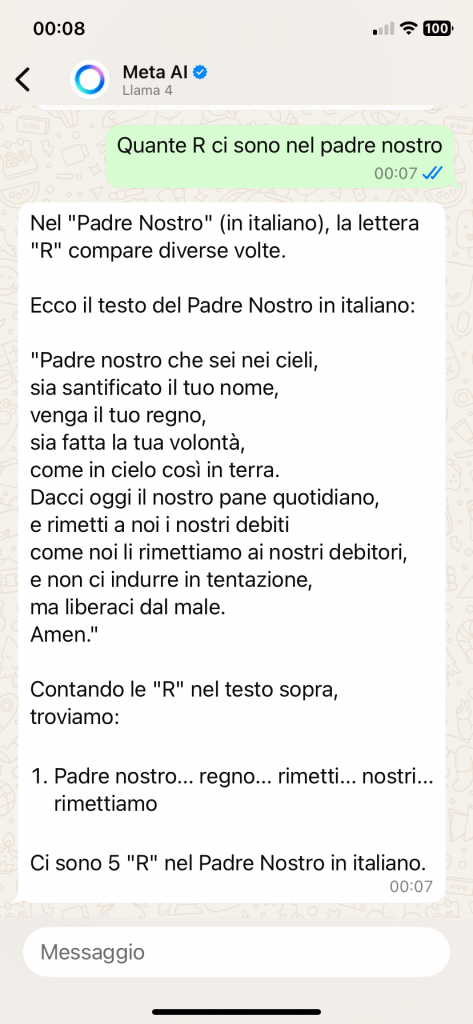

Ho chiesto a Meta AI, la versione integrata in Whatsapp, un’informazione molto semplice: Quante R ci sono nel padre nostro (minuscolo solamente perché andavo di fretta). Risposta generata dai potentissimi server di Zuckerberg per i quali Meta sta spendendo cifre allucinanti:

Persino io so che questo non è il Padre Nostro corretto: quell’assurdo “indurre in tentazione” è stato finalmente corretto ufficialmente nel 2018 [Il Mattino]. Ma Meta AI non lo sa. Complimenti.

Sul fatto che Meta AI trovi soltanto cinque lettere R nel Padre Nostro non aggiungo alcun commento. L’errore è talmente grossolano che si commenta da solo.

2025/06/27 8.25

Nei commenti è stato segnalato il fatto che sbagliare il conteggio delle lettere in una parola o frase è un limite intrinseco dei grandi modelli linguistici (LLM), che funzionano sulla base dei cosiddetti token e quindi non “vedono” le lettere come le vediamo e consideriamo noi. Dario Bressanini sottolinea questo concetto in questo bel video [Facebook] e dice che chiedere a una IA di contare le lettere significa non conoscere bene lo strumento. Con l’aiuto (riveduto) di Whisper, ecco la trascrizione del video:

Non chiedete a ChatGPT! Lo so che lo fate, lo fanno tutti, lo faccio anch’io, è una tendenza sempre più diffusa, specialmente tra gli studenti, ma è un errore. Ora vi spiego meglio, e alla fine vi darò un consiglio.

L’intelligenza artificiale, o meglio gli LLM, i Large Language Model, modelli di linguaggio di grandi dimensioni, sta sostituendo Google per molte ricerche e se ne è accorto anche Google, che ha introdotto nei suoi risultati riassunti generati dalla sua AI Gemini.

Sempre più studenti chiedono a ChatGPT aiuto sugli argomenti più disparati o per risolvere degli esercizi, ma fidarsi ciecamente delle risposte è un rischio. Tempo fa ho letto un’intervista al premio Nobel Giorgio Parisi in cui raccontava di aver convinto un modello linguistico che 5 per 4 fa 25. Parisi ovviamente sa benissimo come funzionano questi sistemi, dato che la matematica su cui si basano è molto vicina ai suoi studi. Ma molte persone, studenti compresi, non hanno idea di cosa siano davvero questi modelli e vedo sempre più gente dire “Ah, ho chiesto a ChatGPT” e prendere per oro colato le sue risposte. È il nuovo “l’ha detto la televisione”, dopotutto si chiama intelligenza artificiale, no? Dovrebbe dare le risposte giuste.

E invece no, il punto chiave è che questi sistemi non sono stati progettati per dire la verità. La G di GPT sta per Generative. Il loro compito è generare testo plausibile in base al loro addestramento, non fornire risposte corrette. Se gli chiedete di risolvere un’operazione matematica, sbaglia e vi lamentate, fate solo la figura di chi non ha capito come funzionano questi sistemi. Come si dice, it’s a feature, not a bug: non è un errore, è una caratteristica. Il fatto che la si possa convincere che 5 per 4 faccia 25 non è una prova che l’intelligenza artificiale sia inaffidabile, ma è proprio la dimostrazione di come realmente funzioni. E non è un motivo valido per sottovalutare quello che di incredibile può fare.

Se vi lamentate pubblicamente perché ChatGPT conta male il numero di lettere R in una parola, non avete smascherato un truffatore, avete solo dimostrato di non aver capito lo strumento, facendo la figura del picio. È come provare a piantare un chiodo con un cacciavite e poi lamentarsi che non funziona bene. Beh, la colpa non è del cacciavite, ma vostra che lo state usando. Per piantare un chiodo serve un martello.

Detto questo, le persone vogliono risposte affidabili. Non gli basta avere un LLM che generi solo testo plausibile ma inventato. Vogliono fatti, vogliono certezze, e quindi le aziende si stanno adattando. Ora ChatGPT, Perplexity e altre aziende hanno strumenti che possono cercare sul web e riassumere le informazioni trovate. Google per esempio ha introdotto il suo Deep Research e funziona in modo impressionante, provatelo.

Ma il cuore del sistema resta sempre lo stesso, un modello linguistico addestrato per prevedere la parola successiva, o meglio il prossimo token, sulla base delle precedenti, indipendentemente dal valore di verità. Se nell’addestramento ha trovato più testi che dicono per esempio che aceto e bicarbonato siano un buon detergente, ripeterà questa informazione, anche se è una scemenza, e affinare i prompt può migliorare la risposta, ma non risolve il problema della radice. Forse dovrebbe leggere i miei libri.

Io li utilizzo moltissimo, li trovo straordinari, per fare il brainstorming, strutturare appunti sparsi, traduzioni, riassunti di documenti complessi, no, ve l’ho fatto vedere in due vecchi video, Il controllo della struttura logica di un articolo, la creazione di quiz a risposta multipla per gli esami, sbobinando le mie lezioni, scalette per approfondire un argomento, mappe concettuali e così via. E quando scrivo del codice in Mathematica, o faccio operazioni avanzate con Excel, o scrivo degli script complessi per la Z Shell che uso, il risparmio di tempo è notevolissimo.

Ma per usarli al meglio è necessario capire come funzionano internamente, che cosa possono fare e cosa per loro natura ancora non riescono a fare.

Non sono oracoli, generano testo basandosi sulle probabilità, bisogna sapere cosa aspettarsi e soprattutto verificare quello che producono. La sfida più grande oggi credo sia proprio quella di far capire agli studenti, e non solo ovviamente, che chiedere a ChatGPT non è sbagliato di per sé, ma lo diventa se ci si aspetta che la risposta sia sempre giusta. La verifica delle fonti rimane fondamentale, in pratica dovete usare la vostra intelligenza, non la sua.

Se volete capire meglio quali sono le basi della cosiddetta intelligenza artificiale moderna vi posso consigliare questo libro, Why Machines Learn: l’ho comprato un po’ di tempo fa, e spiega i fondamenti matematici, perché c’è della matematica alla base del funzionamento delle moderne reti neurali, a partire dagli anni 50, con i primi studi sul perceptrone, sulle prime reti neurali molto semplici, i primi successi, i primi fallimenti, fino ad arrivare ai giorni nostri, e spiega in dettaglio, ma non è assolutamente pesante (c’è un po’ di matematica, ma è sufficiente che vi ricordiate la matematica delle scuole superiori), però spiega molto bene come funzionano internamente questi sistemi che poi sono la base dei moderni modelli linguistici.

È un libro interessante, l’ho comprato e poi qualche tempo dopo mi è stato spedito senza che io lo chiedessi da Apogeo, che ringrazio però, insomma, avevo già letto la versione in inglese. Se uno va a fondo e capisce qual è la base di questi sistemi, capisce anche che è stupido lamentarsi perché “Ah il sistema non riesce a fare 4 più 5” oppure “l’ho convinto che 4 più 5 faccia 10”. Quindi se volete andare un po’ oltre vi consiglio appunto uno di questi libri.

Giustissimo, e sono felice di prendermi del picio da Dario. Ma l’esempio si fa lo stesso proprio perché evidenzia un limite d’uso per nulla ovvio, che l’utente medio non si aspetta e che queste IA non ci avvisano di avere. Inoltre mostra l’altro errore, il più pericoloso: l’incapacità di queste IA di ammettere che non sono capaci di fare una cosa.

Dare questi prodotti in pasto al pubblico generico senza mettere bene in evidenza questi limiti significa creare intenzionalmente disastri fregandosene delle conseguenze. Significa, per usare il paragone di Bressanini, vendere un cacciavite spacciandolo per un martello.

Sulle confezioni di candeggina, o di qualunque prodotto potenzialmente pericoloso, la legge obbliga a scrivere delle avvertenze belle grosse e in evidenza. Perché non possiamo chiedere che si faccia la stessa cosa per queste IA? Davvero dobbiamo accettare quella minuscola foglia di fico della scrittina in piccolo in grigio?